В Google Drive появилась полезная функция бэкапа отдельных папок на компьютере. Стандартное приложение Drive раньше синхронизировало файлы и документы только расположенные внутри своей папки. Я раньше как-то искал варианты, как синхронизировать другие папки, напрашивалось решение использовать символические ссылки, но в Windows это не работало. Теперь это отдельная функциональность встроенная и в Google Drive и в приложение на десктопе. Причём, новое приложение заменяет и Google Photos, которое умело бэкапить только фото и видео.

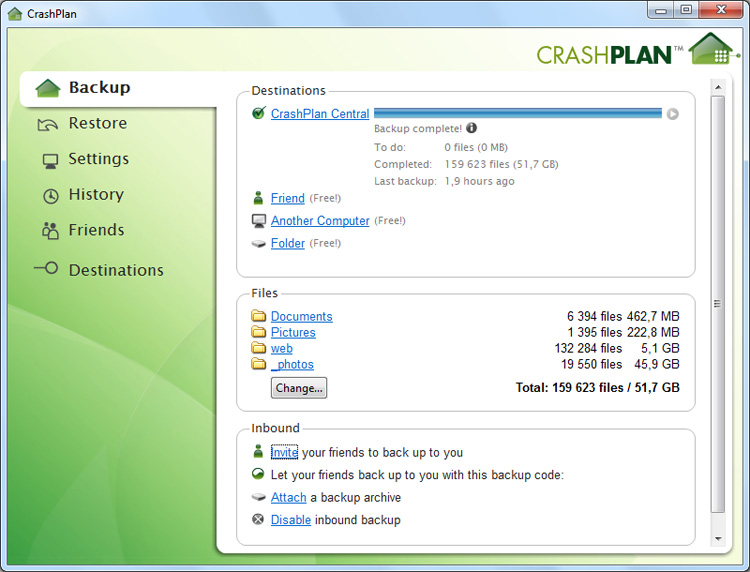

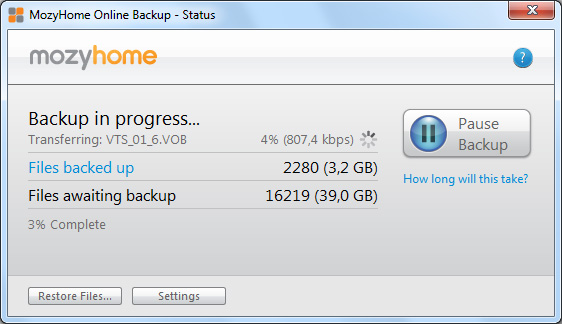

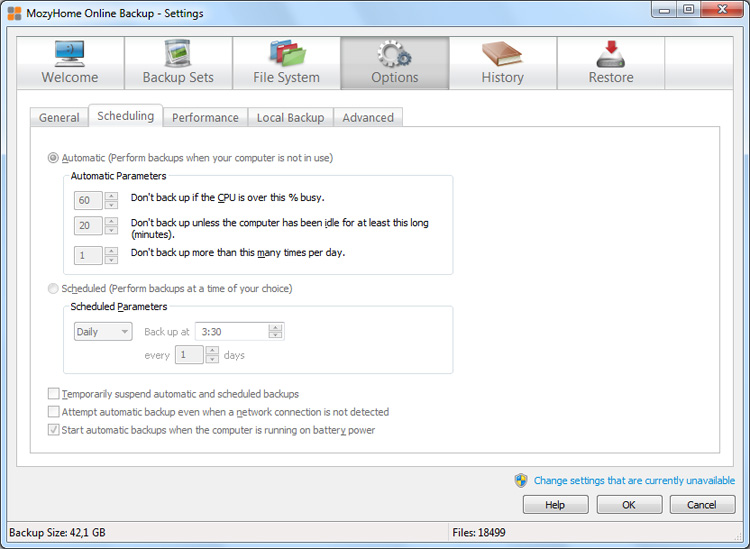

Сейчас я использую Crashplan для автоматического бэкапа папок на компьютере и рабочем ноутбуке. Раньше писал о нём обзор: https://www.kushnerov.com/2011/04/24/crashplan/, получается использую его уже 6 лет. Приложение неплохое, но у него есть ряд недостатков.

- Первый — не очень высокая скорость бэкапа, сейчас это уже не так актуально как раньше, но раньше после 100 гигабайт, он начинал работать ну очень медленно. Это явно, встроенное ограничение, при задекларированном неограниченном пространстве храниения, ты можешь закачать сколько хочешь, но каждый последующий гигабайт будет сохраняться медленее и медленнее.

- Второй — похоже, что хранится только одна копия моих данных, что не очень надёжно.

- Третий — было пару раз, когда приложение просто перестаёт загружаться при загрузке компьютера. То есть неожиданно бэкап перестаёт работать и обнаружить это удаётся через несколько дней по письму от системы, что бэкап не идёт уже несколько дней.

Подумаем о плюсах бэкапа в Google Drive

- Данные точно хранятся в 3-копиях, как и всё в Google, риск потери крайне низкий

- Закачанные фото и видео сразу доступны в Google Photos — откуда их удобно смотреть с телефона

Минусы:

- Нет дополнительной защиты — пароля, который дополнительно шифрует данные, чтобы их нельзя было просто скачать при получении доступа к аккаунту

- При поиске в Google Drive, выдаёт результаты не только по диску, но и по сохранённым файлам с компьютеров

Бэкапить данные в Google Drive пока выглядит надёжней и удобней, только стоит ещё более серьёзно озаботиться проблемой защиты доступа к аккаунту, надеюсь, что двухфакторная авторизация это решает. Решил попробовать использовать месяц оба бэкапа для точного сравнения.

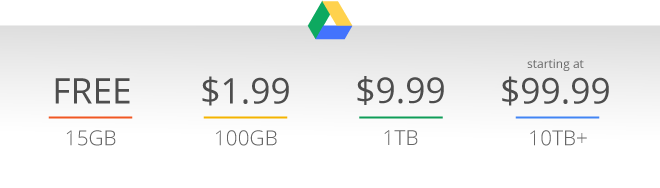

Также нужно понимать, что фактически несмотря на бесплатность Google, новая фича платная — так как по умолчанию в вашем аккаунте Google всего 15 гигабайт места (30, если он корпоративный). Это включает в себя и почту и фотографии и файлы на Google Drive. Так как фотографии и видео обычного размера и документы формата Google не занимают место, фактически это место используется под вложения для почты. 15 гигабайт места это немного, можно забэкапить папки только с основными документами, например, у меня сейчас около 350 гигайбайт ресурсов, которые нужно сохранять, в основном это фотографии. Но место можно купить, 100 Гигайбайт дополнительного места стоят 1,99 $ в месяц, а 1 терабайт 9,99 $. За Crashplan сейчас я плачу 13,99 $ в месяц, он позволяет бэкапить несколько устройств (есть план, где для одного устройства за 5,99 $). То есть 1 терабайт мне точно хватит и будет это дешевле чем Crashplan.